Von Überanpassung spricht man, wenn ein Modell genau zu seinen Trainingsdaten passt. Die Qualität eines Modells verschlechtert sich, wenn das von Ihnen trainierte Machine-Learning-Modell sich zu sehr an die Trainingsdaten anpasst, anstatt neue und unbekannte Daten zu verstehen.

Es gibt verschiedene Gründe, warum es zu einer Überanpassung kommen kann. Die Anwendung verschiedener hochmoderner Techniken kann hilfreich sein, um diesen Ursachen entgegenzuwirken.

Der heutige Artikel beleuchtet Overfitting, häufige Gründe dafür, das Erkennen von Overfitting in Modellen des maschinellen Lernens und einige bewährte Methoden zur Vermeidung von Overfitting beim Training von Modellen des maschinellen Lernens.

In diesem Artikel besprechen wir:

- Was ist Überanpassung?

- So kommt es zu Überanpassung

- So erkennen Sie Überanpassung

- So verhindern Sie Überanpassung

Lass uns anfangen!

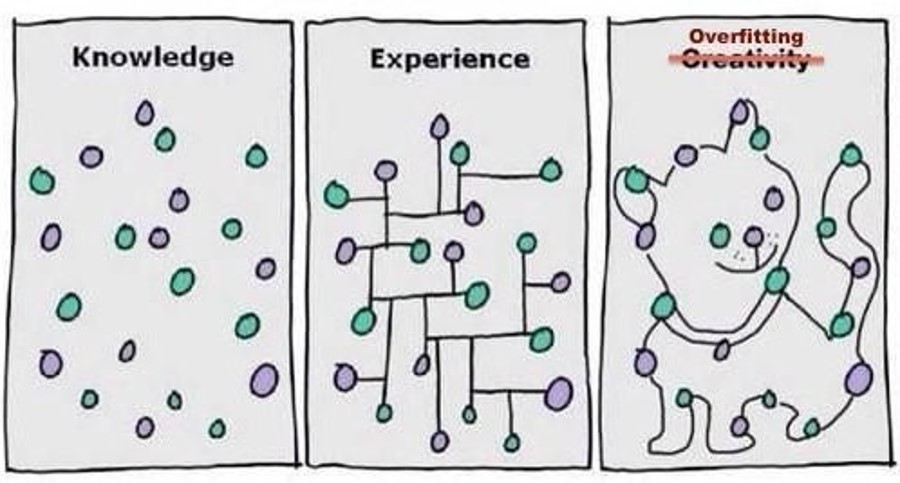

Was ist Overfitting?

Überanpassung ist ein Problem, bei dem ein maschinelles Lernmodell nicht genau auf seine Trainingsdaten passt . Überanpassung tritt auf, wenn das statistische Modell versucht, alle oder mehr als die erforderlichen Datenpunkte der sichtbaren Daten abzudecken. Wenn Überanpassung auftritt, ist die Leistung eines Modells bei den unsichtbaren Daten sehr schlecht.

Wenn ein Modell überangepasst ist, beginnt es, zu viel Rauschen und zu ungenaue Werte aus den Trainingsdaten zu lernen und kann zukünftige Beobachtungen nicht vorhersagen, was zu einer Verringerung der Präzision und Genauigkeit des Modells führt.

Stellen Sie sich folgendes Szenario vor: Sie haben 100 Bilder, davon 50 Katzen und 50 Hunde. Wenn Sie ein Bildklassifizierungsmodell trainieren, zeigt das Modell eine Genauigkeit von 99 % im Trainingsdatensatz, aber nur eine Genauigkeit von 45 % im Testdatensatz, was darauf hinweist, dass Ihr Modell überangepasst ist.

Das bedeutet, dass das Modell die Klasse eines Hundes genau vorhersagt, wenn Ihnen ein Bild eines Hundes aus dem Trainingsset vorgelegt wird. Bei einem zufälligen Hundebild aus dem Internet liefert das Modell jedoch kein korrektes Ergebnis.

Unser Klassifikatormodell für maschinelles Lernen ist überangepasst. Der Klassifikator hat gelernt, bestimmte Merkmale von Katzen und Hunden zu erkennen, aber das Modell hat nicht genügend allgemeine Merkmale gelernt, um bei ungesehenen Bildern leistungsfähig zu sein. Dieses Modell ist daher nicht für den Einsatz in der realen Welt bereit, da die Ergebnisse unzuverlässig wären.

Wie kommt es zu Überanpassung?

Es gibt mehrere Gründe, warum Sie in Ihren Machine-Learning-Modellen Überanpassung feststellen können. Lassen Sie uns einige der häufigsten Ursachen für Überanpassung besprechen:

- Wenn ein Modell eine hohe Varianz und eine geringe Verzerrung aufweist , erhöht sich die Trainingsgenauigkeit, aber die Validierungsgenauigkeit verringert sich mit der Anzahl der Epochen.

- Wenn der Datensatz verrauschte Daten oder ungenaue Punkte (Müllwerte) enthält , kann dies die Validierungsgenauigkeit verringern und die Varianz erhöhen.

- Wenn das Modell zu komplex ist , steigt die Varianz und die Verzerrung ist gering. Es kann zu viel Rauschen oder zufällige Schwankungen anhand der Trainingsdaten lernen, was die Leistung von Daten beeinträchtigt, die das Modell noch nie zuvor gesehen hat.

- Wenn die Größe des Trainingsdatensatzes nicht ausreicht , kann das Modell nur einige der Szenarien oder Möglichkeiten untersuchen. Bei der Einführung unbekannter Daten ist die Genauigkeit der Vorhersage geringer.

Überanpassung in Modellen des maschinellen Lernens erkennen

Das Erkennen von Überanpassung ist eine komplexe Aufgabe, bevor Sie die Daten testen. Am besten beginnen Sie so schnell wie möglich mit dem Testen Ihrer Daten, um herauszufinden, ob das Modell bei den Datensätzen, mit denen es arbeiten soll, eine gute Leistung erbringt.

Die entscheidende Frage ist: Funktioniert mein Modell gut bei unbekannten Daten? Wenn Ihr Modell bei unbekannten Daten schlecht funktioniert und diese Daten repräsentativ für die Art von Daten sind, mit denen Sie Ihr Modell füttern, ist möglicherweise eine Überanpassung aufgetreten.

Einige Dinge deuten jedoch darauf hin, dass Ihr Modell zu viel aus dem Trainingsdatensatz lernt und überangepasst ist. Dies sind:

Wenn Sie Ihren Datensatz in Training, Validierung und Test aufteilen , sollten Sie darauf achten, dass Ihre Datensätze in zufälliger Reihenfolge vorliegen. Das ist entscheidend. Wenn Ihre Datensätze nach einem bestimmten Attribut (z. B. Hausgröße in Quadratmetern) sortiert sind, lernt Ihr Trainingsdatensatz möglicherweise nichts über die Extremfälle (riesige Hausgrößen), da diese nur in Validierungs- und Testsätzen vorkommen.

Darüber hinaus kann Ihnen die Lernkurve mehr Informationen liefern, als Sie vielleicht denken. Lernkurven sind Diagramme der Lernleistung eines Modells im Zeitverlauf, wobei die Y-Achse eine Lernmetrik ( Klassifizierungsgenauigkeit oder Klassifizierungsverlust) und die X-Achse die Erfahrung (Zeit) darstellt. Wenn der Trainingsfehler mit zunehmender Anzahl von Iterationen abnimmt, ändert sich der Validierungsfehler nicht und erhöht sich auch nicht. Dies weist darauf hin, dass das Modell überangepasst ist, und Sie können das Training beenden.

So verhindern Sie Überanpassung

Aufgrund der Komplexität der Anzahl der beteiligten Parameter neigen Machine-Learning-Modelle zu Überanpassung. Um Überanpassung zu vermeiden, ist es wichtig, die verwendeten Methoden zu verstehen.

Weitere Trainingsdaten hinzufügen

Das Hinzufügen weiterer Trainingsdaten ist die einfachste Möglichkeit, Abweichungen zu beheben, wenn Sie auf mehr Daten und Rechenressourcen zugreifen können, um diese Daten zu verarbeiten. Mehr Daten helfen Ihrem maschinellen Lernmodell, allgemeinere Merkmale zu verstehen, anstatt Merkmale, die für Bilder im Datensatz spezifisch sind. Je mehr allgemeine Merkmale ein Modell identifizieren kann, desto unwahrscheinlicher ist es, dass Ihr Modell nur bei sichtbaren Bildern gute Ergebnisse liefert.

Datenerweiterung nutzen

Wenn Sie keinen Zugriff auf weitere Daten haben, sollten Sie eine Datenerweiterung in Betracht ziehen. Mit der Datenerweiterung können Sie verschiedene Transformationen auf den vorhandenen Datensatz anwenden, um die Datensatzgröße künstlich zu erhöhen. Die Erweiterung ist eine gängige Technik, um die Stichprobengröße von Daten für ein Modell zu erhöhen, insbesondere in der Computervision.

Standardisierung

Standardisieren Sie die Features so, dass jedes Feature einen Mittelwert von 0 und eine Varianz von 1 hat. Diese Änderung dient der Beschleunigung des Lernalgorithmus. Ohne normalisierte Eingaben können die Gewichte erheblich variieren, was zu Überanpassung und hoher Varianz führt.

Merkmalsauswahl

Ein häufiger Fehler besteht darin, die meisten oder alle vorhandenen Merkmale einzubeziehen, unabhängig davon, wie viele Punkte für jedes Merkmal verfügbar sind. Dies stellt ein Problem dar, da es für ein Modell aufgrund geringer Stichprobengrößen bei Merkmalen schwierig ist, zu verstehen, wie ein Merkmal allgemeiner auf die Daten in einem Datensatz zutrifft.

Fragen Sie sich: Verfügt Ihr Datensatz über viele Merkmale, aber nur wenige Datenpunkte für jedes Merkmal? Wenn dies der Fall ist, sollten Sie nur die wesentlichen Merkmale auswählen, die für das Training erforderlich sind.

Kreuzvalidierung

Mithilfe der Kreuzvalidierung verwenden Sie alle Daten zum Training, indem Sie den Datensatz in k-Gruppen aufteilen und jede Gruppe als Testsatz verwenden. Wiederholen Sie den Vorgang k-mal für jede Gruppe als Testsatz.

Frühzeitiges Stoppen

Der Punkt, an dem Sie den Trainingsprozess beenden sollten, ist, wenn Ihr Validierungsverlust zu steigen beginnt. Wir können dies erreichen, indem wir Lernkurven überwachen oder einen Auslöser für frühzeitiges Beenden festlegen.

Sie sollten mit verschiedenen Stoppzeiten experimentieren, um herauszufinden, was für Sie am besten funktioniert. Im Idealfall beenden Sie das Training genau bevor das Modell voraussichtlich mit dem Lernen von Rauschen im Datensatz beginnt. Sie können dies erreichen, indem Sie mehrere Male trainieren und ungefähr herausfinden, an welchem Punkt Rauschen beginnt, Ihr Training zu beeinträchtigen. Ihre Trainingsdiagramme helfen Ihnen dabei, den optimalen Zeitpunkt für das Beenden des Trainings zu ermitteln.

Bedenken Sie: Wenn Sie das Training zu früh beenden, ist die Leistung Ihres Modells möglicherweise nicht so hoch, als wenn Sie das Training etwas länger dauern würden.

Ensemble

Bei dieser Technik kombinieren wir mehrere strategisch erstellte Modelle, wie Klassifikatoren oder Experten, um eine bessere Vorhersageleistung zu erzielen. Dadurch wird die Varianz reduziert, die Verzerrung der Modellierungsmethode minimiert und die Wahrscheinlichkeit einer Überanpassung verringert.

Regulierung

Dies ist eine trendige Technik im maschinellen Lernen, die darauf abzielt, die Komplexität des Modells zu verringern, indem die Varianz deutlich reduziert wird, während die Verzerrung nur geringfügig erhöht wird. Die am häufigsten verwendeten Regularisierungsmethoden sind L1 (Lasso), L2 (Ridge), Elastic Net, Dropout, Batch-Normalisierung usw.

Kann Overfitting beim maschinellen Lernen ein gutes Ergebnis sein?

Während die Überanpassung von Machine-Learning-Modellen normalerweise tabu ist, ist sie heute gang und gäbe, wenn es darum geht, das Risiko von Computer-Vision-Modellen für den späteren Einsatz in Geschäftsanwendungen zu verringern. Bevor Ihr Unternehmen Zeit und Mühe in ein Computer-Vision-Projekt investiert, ist es möglicherweise an einem Punkt angelangt, an dem es lieber prüfen möchte, ob die Aufgabe überhaupt durch ein Modell „erlernbar“ ist.

Dies kann erreicht werden, indem Sie ein überangepasstes Modell erstellen. Nachdem Sie Bilder gesammelt haben, in denen Sie sich auf die Identifizierung einer Teilmenge der angezeigten Objekte konzentrieren, werden Sie Ihr Modell zwangsläufig mit Trainings- und Validierungsbildern laden, deren Struktur nicht vielfältig genug ist. Dies führt dazu, dass Ihr Modell an diese Umgebung überangepasst ist, da es für die Erkennung der markierten Objekte optimiert ist, die Sie in den Trainingsbildern identifiziert haben confusion matrix.

Ein Projekt, dessen Risiko als erlernbare Aufgabe vollständig entschärft ist, bedeutet, dass wir ein tragfähiges Computer-Vision-Projekt zur Implementierung in unserem Unternehmen haben. Ob es sich bei diesem Anwendungsfall um Arbeitssicherheit, Fehlererkennung, Dokumentenanalyse, Objektverfolgung, Rundfunkerlebnisse, Gaming, Augmented-Reality-Apps oder was auch immer handelt … manchmal ist Overfitting der Beweis, den wir brauchen, um zu bestätigen, dass Vision eine realistische Lösung für ein Problem ist.

Fazit

Overfitting ist ein immerwährendes Problem im Bereich des maschinellen Lernens. Es ist schwierig, die häufigsten Gründe zu verstehen und zu erkennen, wie man Overfitting erkennt. Die im heutigen Artikel besprochenen Standardverfahren helfen Ihnen zu verstehen, wie Sie Overfitting beim Modelltraining angehen können.

Zitieren Sie diesen Beitrag

Verwenden Sie den folgenden Eintrag, um diesen Beitrag bei Ihrer Recherche zu zitieren:

Mrinal Walia . (31. Oktober 2022). Overfitting beim maschinellen Lernen und der Computervision. Roboflow-Blog: https://blog.roboflow.com/overfitting-machine-learning-computer-vision/

Besprechen Sie diesen Beitrag

Wenn Sie Fragen zu diesem Blogbeitrag haben, starten Sie eine Diskussion im Roboflow-Forum .